Wie stark beeinflussen menschliche Entscheidungen im Forschungsprozess die Qualität der empirischen Ergebnisse?

Wie bedeutend ist das menschliche Element für die Genauigkeit empirischer Erkenntnisse in den Wirtschaftswissenschaften? Die Unsicherheit empirischer Schätzungen wird üblicherweise als ein statistisches Phänomen betrachtet. Unbekannte Parameter einer Grundgesamtheit werden anhand einer Stichprobe geschätzt, deren Erzeugung zu so genannten Standardfehlern führt. Forschende treffen jedoch viele unbeobachtete Entscheidungen, die nicht per se richtig oder falsch sind, sich aber auf das Ergebnis der Schätzung auswirken. Beispiele hierfür sind die Wahl der Software, die Art der Datenbereinigung oder die Spezifikation der Kontrollvariablen, um nur einige zu nennen. Wir haben an einem großen crowd-basierten Feldexperiment teilgenommen, bei dem sich herausstellte, dass dieser evidenzgenerierende Prozess von Forscher zu Forscher stark variiert, wodurch eine neue Art von Unsicherheit entsteht: so genannte Nicht-Standardfehler (NSE). 164 Teams von Finanzökonominnen und Finanzökonomen testeten sechs Hypothesen an einer identischen Stichprobe von Finanzmarktdaten. Das wichtigste Ergebnis ist, dass die Nicht-Standardfehler beträchtlich sind und die gleiche Größenordnung haben wie die Standardfehler, dass sie aber nach einem anonymen Begutachtungsprozess deutlich abnehmen. Wer sich von Wirtschaftsforschern beraten lässt, sollte sich daher darüber im Klaren sein, dass die Entscheidungen der einzelnen Forschenden die empirische Evidenz mit einer nicht unerheblichen Unsicherheit behaften. Gleichzeitig scheint eine der Veröffentlichung vorausgehende Begutachtung der Ergebnisse durch wissenschaftliche Kollegen (peer-review) die Anfälligkeit für diese Art von Unsicherheit zu verringern.

23. December 2022

Contents

Page 1

Rat von ExpertenPage 2

ProjektentwurfPage 3

Tragen Peer-Effekte dazu bei, Nicht-Standardfehler zu reduzieren?Page 4

Endnoten All on one pageRat von Experten

Entscheidungsträger verlassen sich häufig auf den Rat von Experten. Diese Empfehlungen sollten auf Erkenntnissen beruhen, die aus einem transparenten und rigorosen wissenschaftlichen Protokoll resultieren. Ein bekanntes Beispiel sind Politikerinnen, die Virologinnen, Epidemiologen und andere Wissenschaftler konsultieren, um Maßnahmen zur Bekämpfung der COVID-19-Pandemie zu planen und zu beschließen. Beispiele aus dem Bereich der Wirtschaft sind Entscheidungen der Zentralbanken, ob sie ihren geldpolitischen Kurs ändern, oder des deutschen Finanzstabilitätsrats, ob makroprudenzielle Maßnahmen wie der antizyklische Kapitalpuffer aktiviert werden sollen. Diese Entscheidungen haben reale Folgen: Zinserhöhungen zur Eindämmung der Inflation wirken sich negativ auf die Wirtschaftstätigkeit aus, und höhere Eigenkapitalanforderungen an die Banken verringern das Kreditangebot für Unternehmen und Haushalte. In ihrem Bemühen um eine verantwortungsvolle Entscheidungsfindung stützt sich die Wirtschaftspolitik daher häufig auf wissenschaftliche Erkenntnisse, die von Wirtschaftswissenschaftlern erarbeitet wurden, unter Anwendung von Methoden, die in der wissenschaftlichen Gemeinschaft akzeptiert und etabliert sind. Doch wie wichtig ist der „menschliche Faktor“ bei der Gewinnung solcher Erkenntnisse? Forschende müssen bei der Durchführung empirischer Forschung mit so genannten Standard- und Nicht-Standardfehlern umgehen. Standardfehler entstehen bei der Erzeugung von Stichprobendaten. Im Gegensatz dazu resultieren Nicht-Standardfehler (NSE) aus der zusätzlichen Ungewissheit, die durch eine Reihe nicht trivialer Entscheidungen bei der Durchführung empirischer Analysen zur Generierung von Evidenz verursacht wird. So legen Ökonominnen beispielsweise ein geeignetes ökonometrisches Modell fest, bereiten die Daten für die Schätzung auf (z. B. durch Bereinigung von Ausreißern), wählen eine Programmiersprache und treffen viele weitere Entscheidungen dieser Art, wenn sie ökonomische Analysen durchführen.

Ziel des groß angelegten Feldexperiments, an dem wir teilgenommen haben, ist es, das Ausmaß von Nicht-Standardfehlern, die sich aus solchen Entscheidungen ergeben, zu messen und zu erklären. Konkret sollte das Projekt vier Fragen beantworten: 1) Wie bedeutend sind Nicht-Standardfehler für die Forschung im Bereich Finanzen?

2) Lassen sie sich im Querschnitt der Forschenden „erklären“?

3) Verringert ein anonymer Begutachtungsprozess diese Nicht-Standardfehler? 4) Sind sich die Forschenden des genauen Ausmaßes der Nicht-Standardfehler bewusst? Zu diesem Zweck wurden

164 Forschungsteams aus Finanzwissenschaftlern in einem Feldexperiment zusammengestellt, um standardisierte Analysen nach einem vorgegebenen Protokoll durchzuführen.

Die wichtigsten Ergebnisse dieses Feldversuchs sind vierfacher Art. Erstens sind die Nicht-Standardfehler erstaunlich groß, ähnlich groß wie der (mittlere) Standardfehler. Daher sollten sich die Konsumenten wirtschaftswissenschaftlicher Forschung des „menschlichen Elements“ in der Evidenz, die den Empfehlungen der Expertinnen zugrunde liegt, bewusst sein. Zweitens variieren die Nicht-Standardfehler nur geringfügig mit dem Forschungsteam, dem Arbeitsablauf und der Qualität der Forschungspapiere. Daher kann eine Erfolgsbilanz ausgewiesener Expertise oder einfach größere Erfahrung die inhärente Unsicherheit von Expertenempfehlungen nicht beseitigen. Drittens nehmen die Nicht-Standardfehler nach dem anonymen Begutachtungsprozess deutlich ab. Die strenge akademische Praxis des Peer-Review verringert also wirksam die Unsicherheit im Zusammenhang mit von Menschen erzeugter Evidenz. Anders ausgedrückt: Das bloße Vorhandensein von Nicht-Standardfehlern bedeutet nicht, dass wir unsere Entscheidungen nicht mehr auf wissenschaftliche Erkenntnisse stützen sollten – es bedeutet vielmehr, dass die Wissenschaft das am wenigsten schlechte Fundament ist, auf dem wir unsere Entscheidungen aufbauen können. Viertens werden Nicht-Standardfehler von den Beteiligten erheblich unterschätzt. Wenn also selbst die Produzenten von Forschungsergebnissen die Relevanz von Unsicherheit aufgrund idiosynkratischer Entscheidungen nicht angemessen erkennen, ist es von entscheidender Bedeutung, die Adressaten der Forschungsergebnisse noch stärker für die Grenzen wissenschaftlicher Erkenntnis und der aus ihr abgeleiteten Ratschläge zu sensibilisieren.

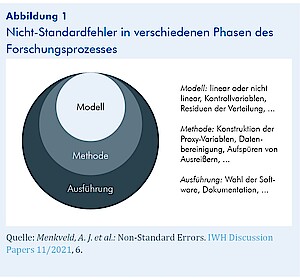

Nicht-Standardfehler

Wie in Abbildung 1 dargestellt, treten bei der Durchführung empirischer Forschung in allen Phasen Nicht-Standardfehler auf. Eine Quelle der Variabilität zwischen den Forschenden ist die Spezifikation des Modells. Ist das empirische Modell linear oder nicht linear? Welche Kontrollvariablen sollten einbezogen werden? Eine weitere Quelle der Variabilität liegt in der Phase der empirischen Methode. Was sind angemessene empirische Näherungswerte für die interessierenden Parameter? Welche Filter sollten auf die Stichprobe angewendet werden? Wie sollten wir Ausreißer in den Daten behandeln? Was sind geeignete Teststatistiken? Die letzte Quelle der Variabilität bezieht sich auf die Ausführungsphase. Können die Ergebnisse ohne Fehler im Programmcode reproduziert werden? In Anbetracht des Freiheitsgrads, den Forschende bei der Durchführung empirischer Forschung haben, und des Problems der Reproduzier- barkeit in der Wirtschafts- und Finanzforschung können potenzielle Nicht-Standardfehler enorm sein.